影像辨識

製作模型

1. 至 "Teachable machine” 中建立圖形專案

( Get Started(開始使用) >> Image Project(圖片專案) >> Standard image mode(標準圖像模型)

2. 允許網路攝影機權限,並將Class1,Class2,Class3類別重新命名station1、station2、background。

3. 更改後,馬上開始蒐集樣本 !

將辨識物(站牌, 空白背景)對準鏡頭,滑鼠按下webcam(網路攝影機)拍攝辨識物的各種

角度和與鏡頭的距離,可以多多嘗試不同的角度與距離 !

(兩個辨識物的照片量各100出頭即可)

4. 拍好之後按下training(訓練),等待模型生成

5. 顯示preview(預覽)後就可以從右上角的選單載下來

(選單>>Download project as file(將專案下載為檔案))

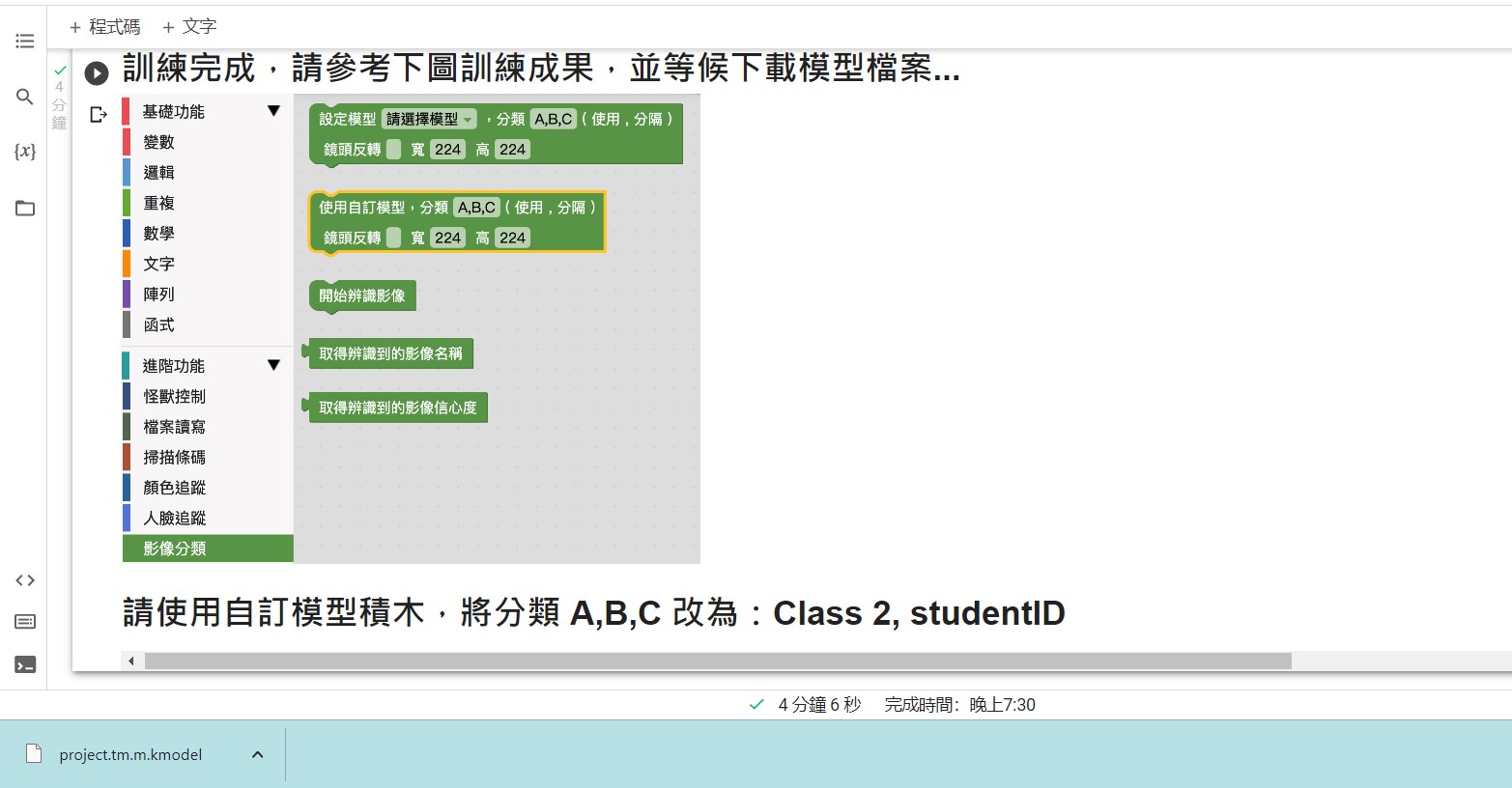

轉換成 kmodel

1. 載下來後到

https://colab.research.google.com/drive/1kV6OOe1OAmHNdpWUx7MURLwoqCC5_YA_

建立副本,將剛剛下載的檔案放入副本中執行

2. 執行成功後,會自動下載kmodle ! 即完成影像辨識模型 !

*如遇上任何關於kmodel無法順利下載的問題,詳見程式區FAQ。

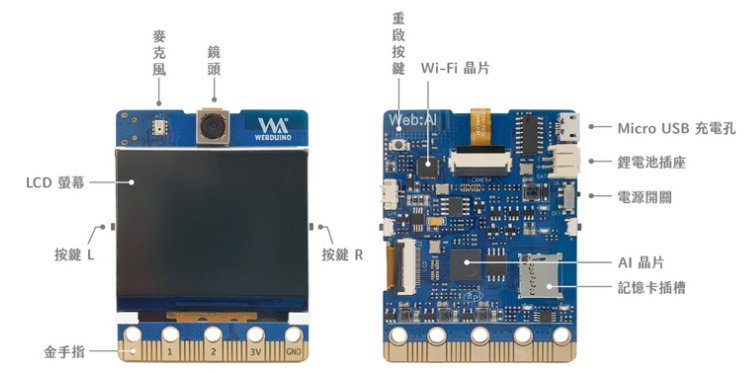

AI 體驗(AI 板)

AI 版介紹

鋰電池充電方式: 電池插著WebAI,關AI板的電源,插USB就可以充電。

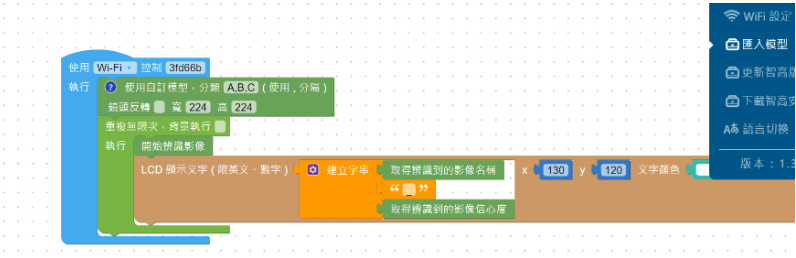

匯入kmodel 使AI板開始影像辨識

1. 登入Webduino

(webduino網站>>教育平台>>web:ai程式積木>>建立帳號登入)

2. 登錄成功後,進入程式積木畫面點選右上角"範例">>左顧右盼,並燒錄程式

(測試web:ai是否正常)

3. 測試成功後,點選"範例">>自訂影像處理

輸入web:ai 板的 Device ID 後,電腦插上AI版,燒錄程式。

4. 選擇匯入剛剛下載的kmodel分類改為自己取名的兩個辨識物名稱

5. AI 板即會開始影像辨識

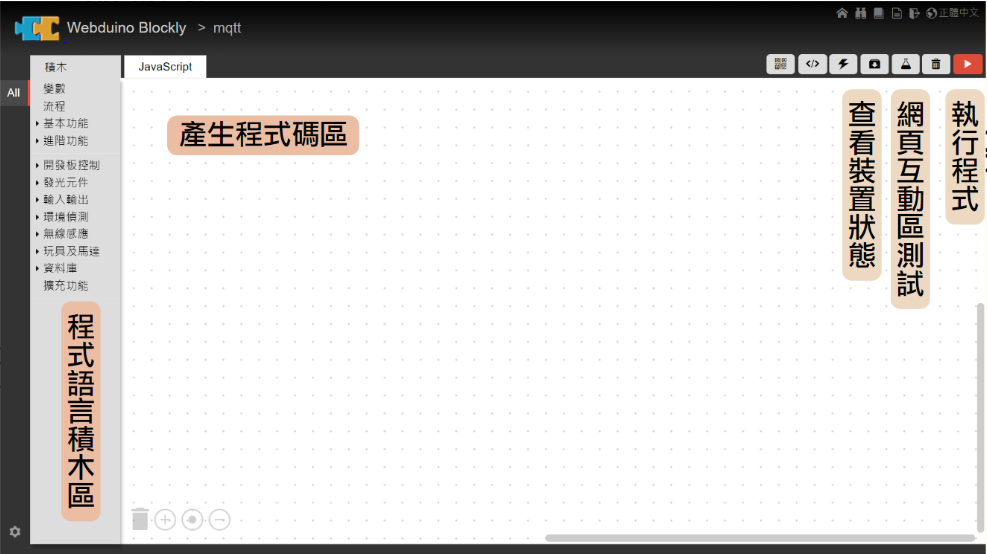

IoT 體驗(Smart 板)

建置Smart 板程式使 MG90s 馬達開始動!

1. 登入 Webduino

(Webduino網站>>教育平台>>smart程式積木>>建立帳號登入>>"我的專案")

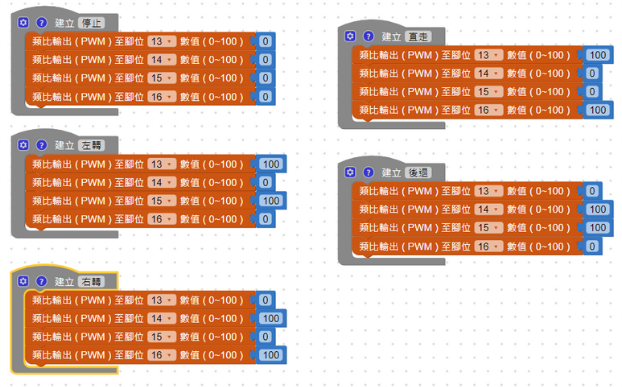

讓機器人可以行走自如-設計前進後退的定義

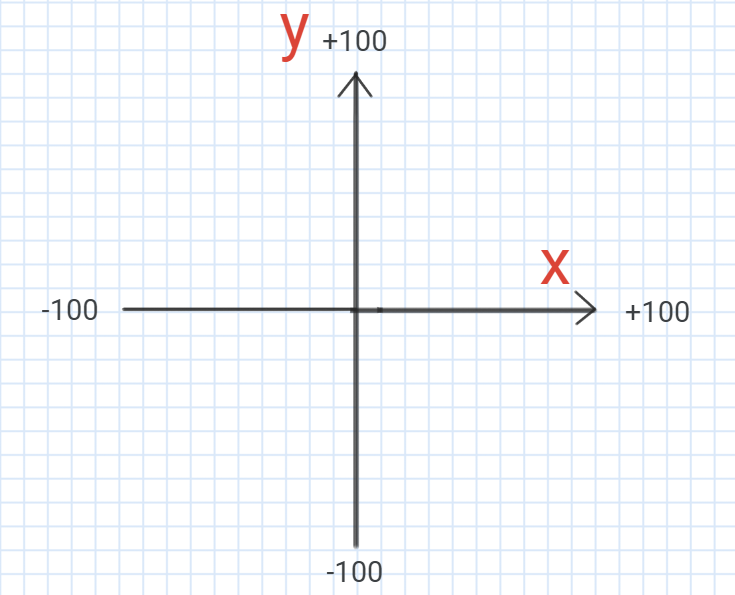

想像機器人站在網格,我們定義往前與往右為正(0~100),往後即往左為負(-100~0)。

而橫向為 x 軸,縱向為 y 軸,如下方圖示。(x, y)即可成為一個座標。

在思考之前,我們要先定義基本移動的函式。請將下圖程式碼拼出來,0~100代表腳位是否輸出能量使相應的馬達轉動。

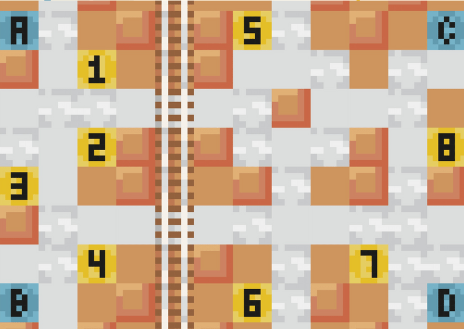

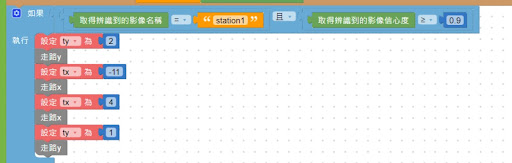

以這樣的定義在以下欄位中填入相關的座標,讓機器人到你像要去的地方。

(以下舉例從 點 D 到 "1"號家)

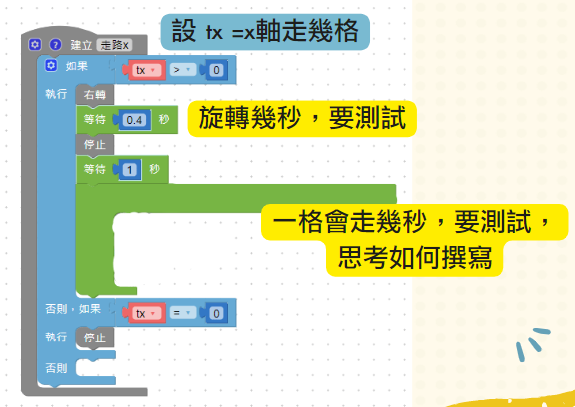

接下來定義走路 x 與走路 y,照著以下的說明撰寫看看走路 x 與 y !

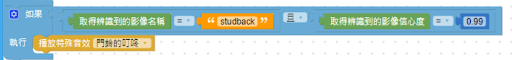

到目的地嗶嗶叫要怎麼做到?

照著以下範本拖拉積木。

可以移動了! 該挑戰拿東西了吧!

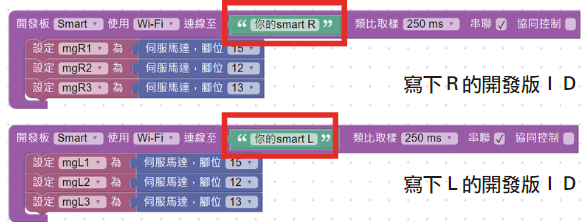

A. 設定馬達腳位

1. 輸入Smart板的 Device ID

2. 串聯 L 跟 R 的Smart 板

3. 將馬達角度歸 0

B. MQTT設定

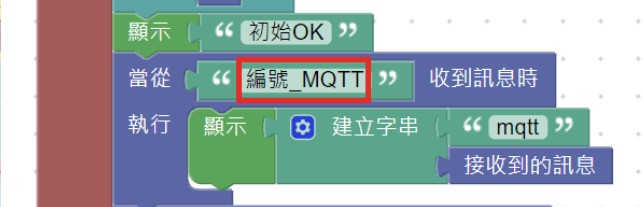

1. 幫每個馬達的MQTT取名字,將(編號)_MQTT輸入至下圖紅框中!

(每個馬達的名字都要是獨一無二的喔!)

2. 設定馬達的MQTT - 接收到訊息就旋轉馬達

(紅框中要改成各馬達的名字喔~,其他馬達依此類推)

3. 思考看看,如果接收到mgR1的訊息時要做甚麼呢? (其他依此類推)

共需要填寫6個喔!(R1、R2、R3、L1、L2、L3)

手臂控制

1. 以安卓(Android)系統裝置掃描下圖QR Code,下載apk檔至手機中

(點進去程式介面如下方第二張圖)

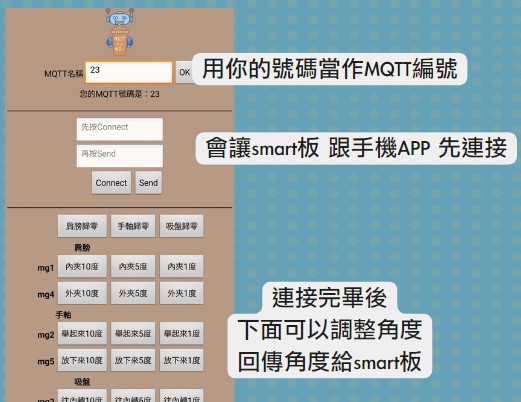

2. 輸入MQTT名稱,並按下「OK」。

3. 按下Connect,再按 Send。

4. 將肩膀、手軸及吸盤歸零。

5. 可以開始用下方的按鈕操控機器人的手臂囉~

這樣就完成機器人的程式部分囉~